? 亮点速览

NanoFlow通过设备内并行和纳米批次技术,将LLM服务吞吐量提升1.91倍,达到理论最优的50%-72%?

? 资源链接

原文链接: arxiv.org/abs/2408.12757

? 中文精读电脑版查看:www.aipaper.cc/zh/paper/691ca07c25edee2b759f339c

? 研究动机

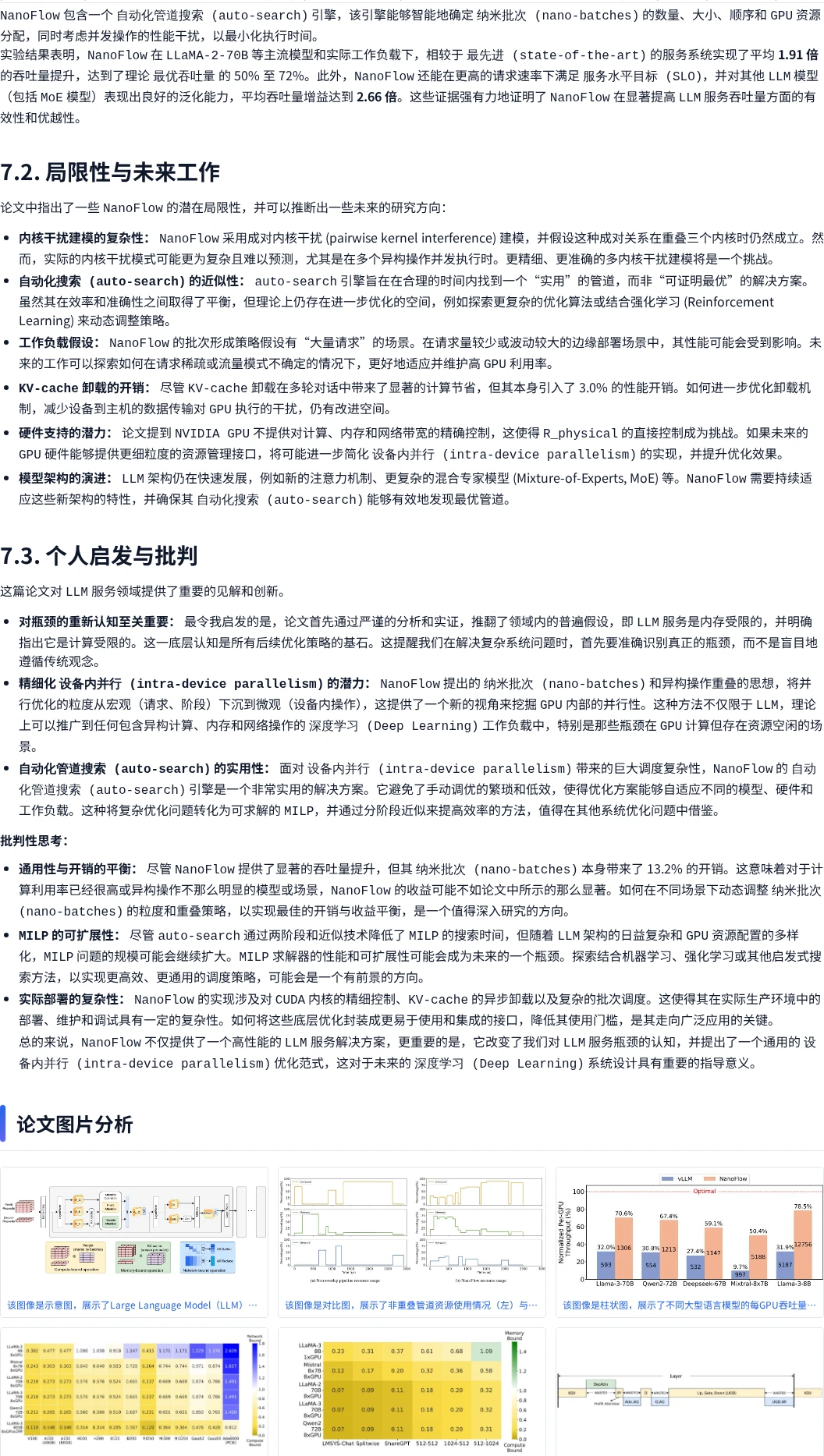

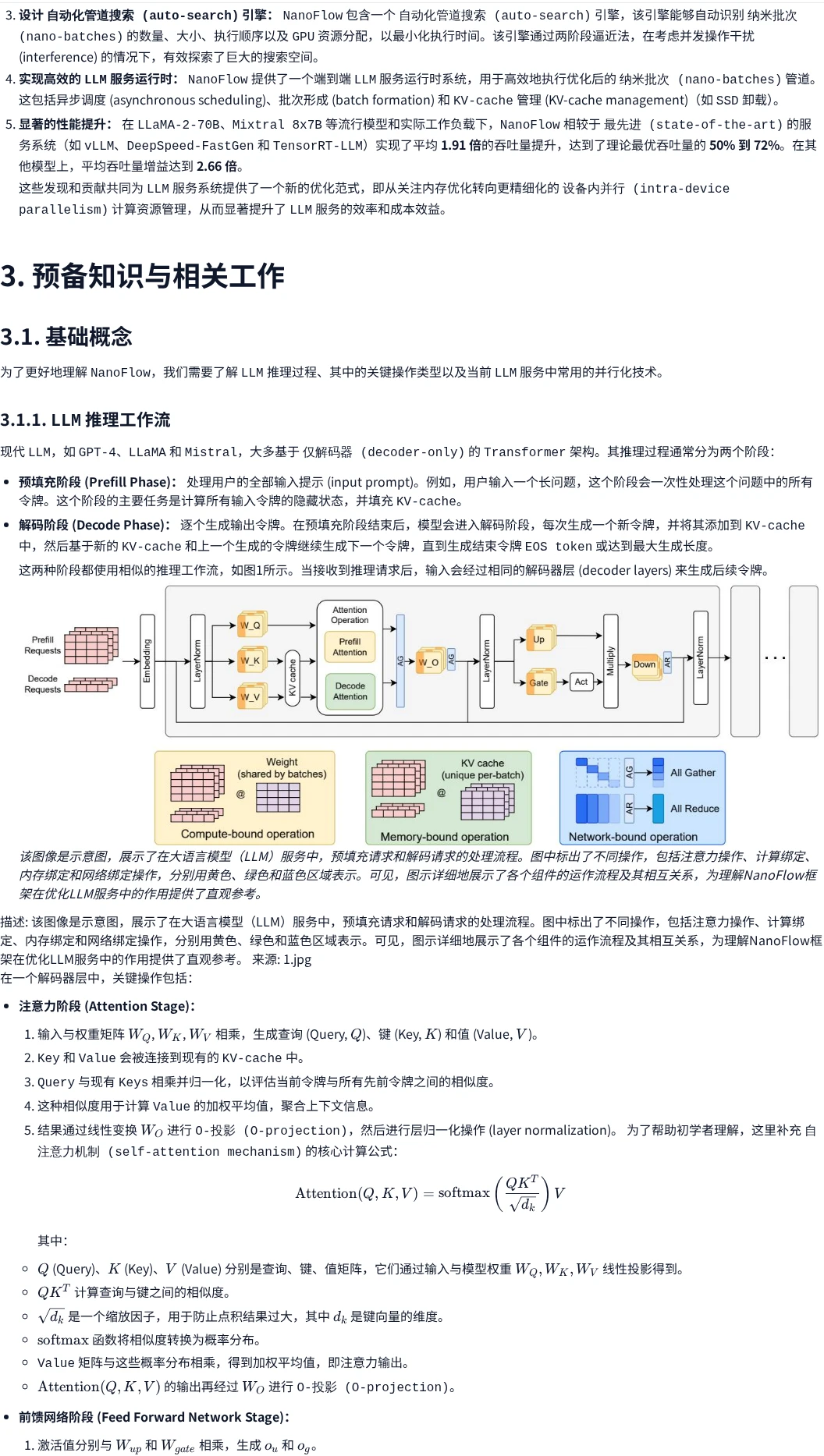

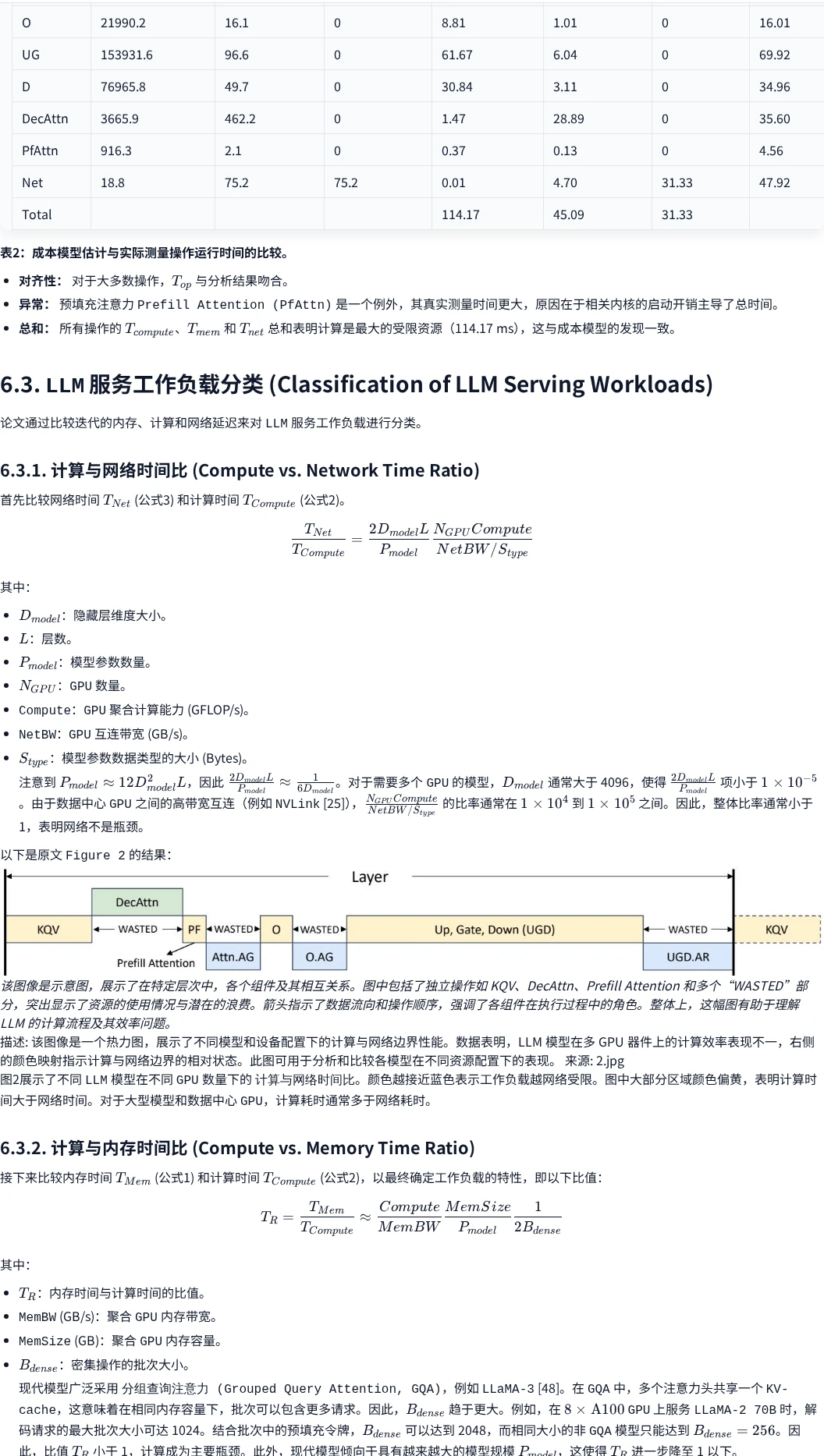

传统观点认为LLM服务是内存受限的,但实际分析发现端到端服务是计算受限的?。现有系统因异构操作顺序执行导致GPU计算资源利用率低下。

?️ 创新方案

NanoFlow框架将输入拆分为纳米批次,通过自动化管道搜索引擎智能调度计算、内存和网络操作的重叠执行。

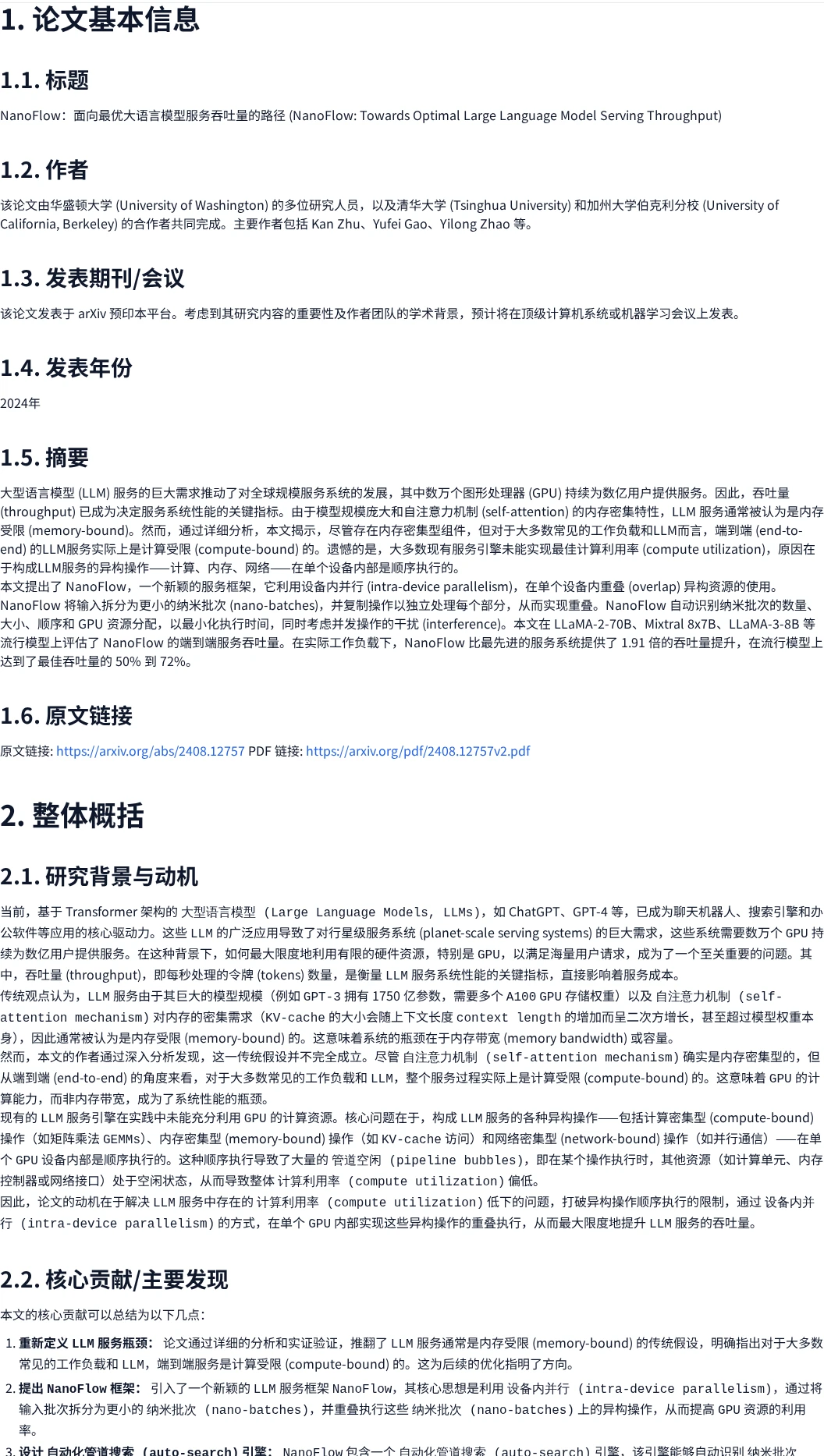

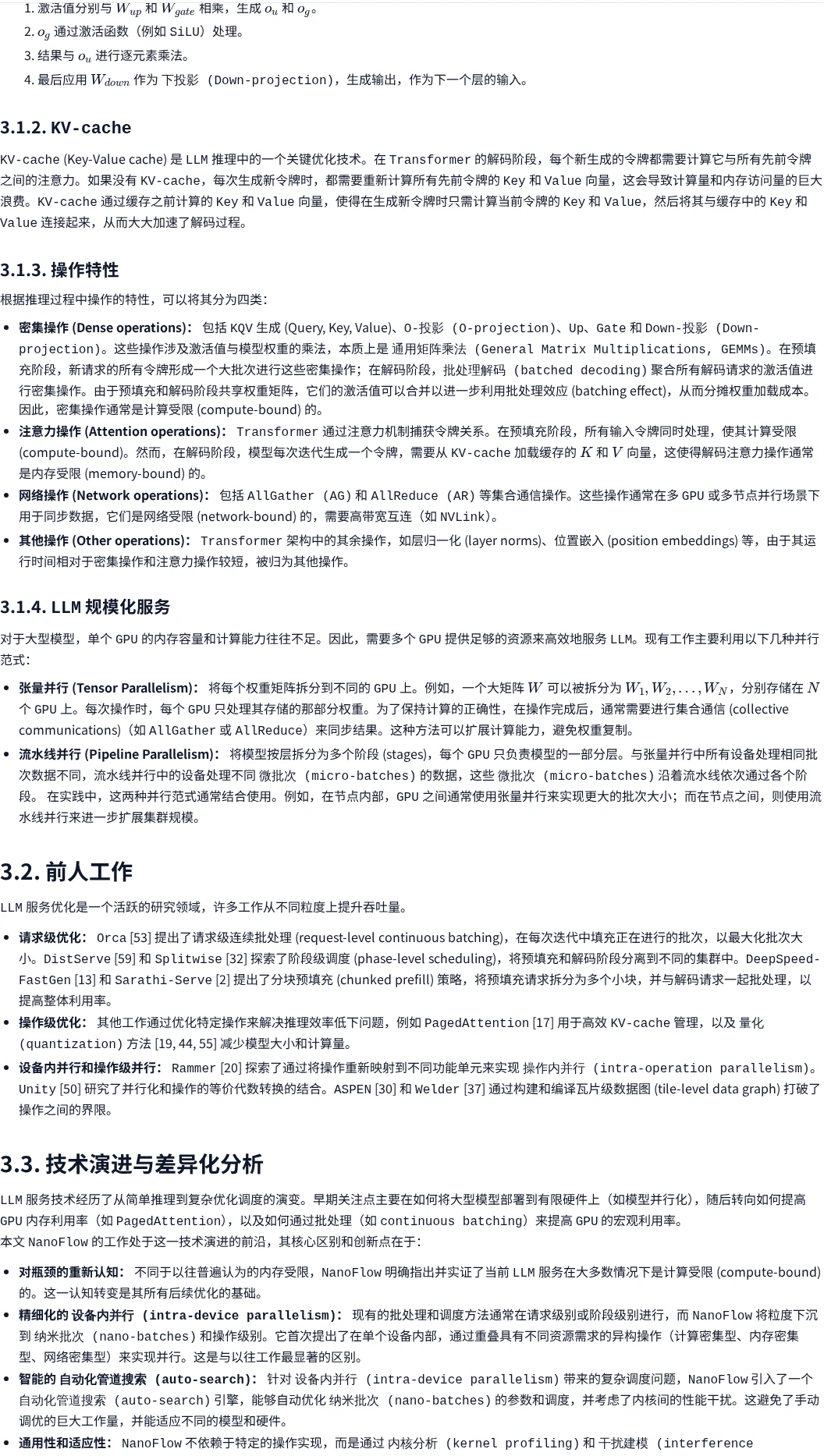

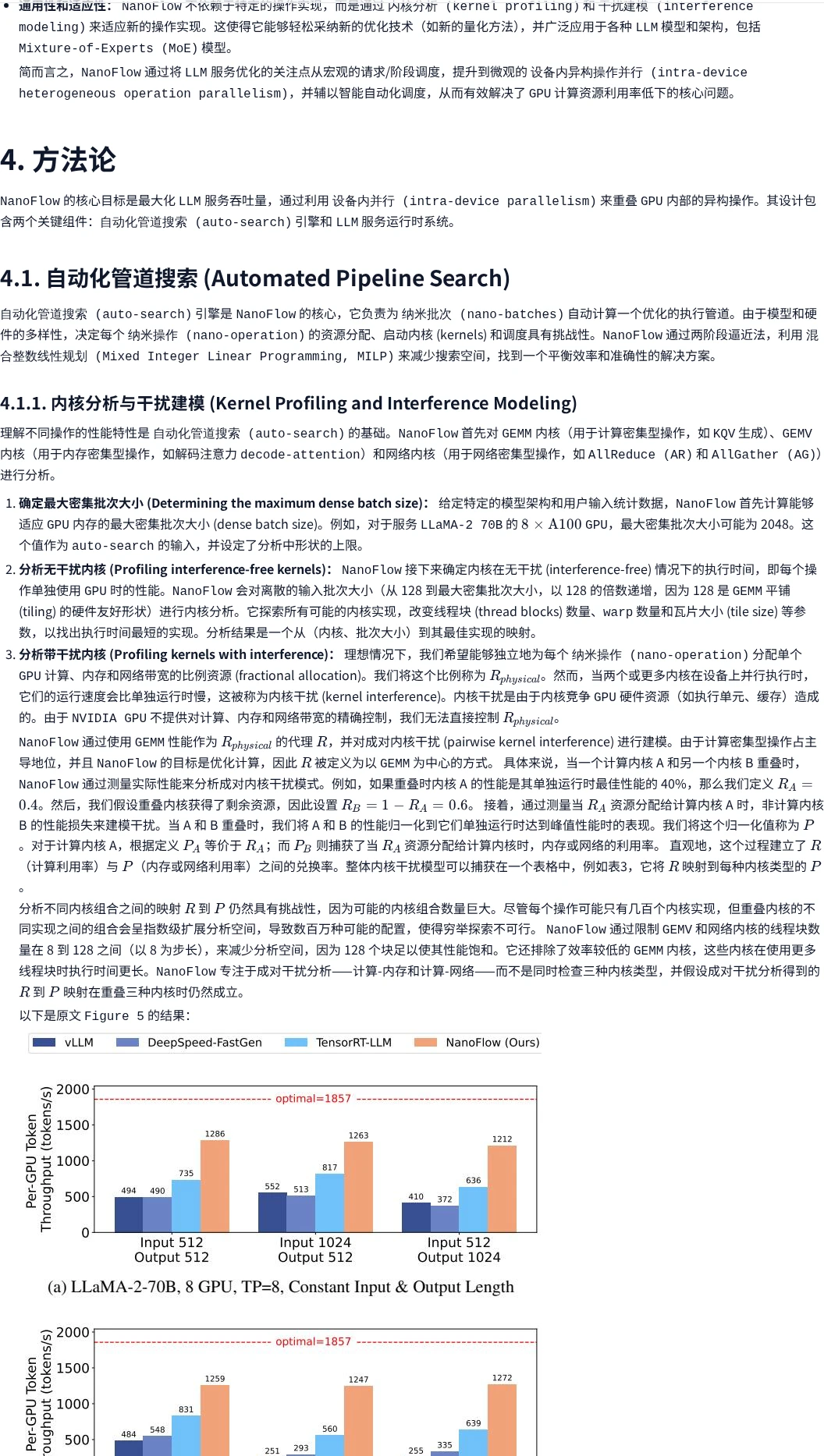

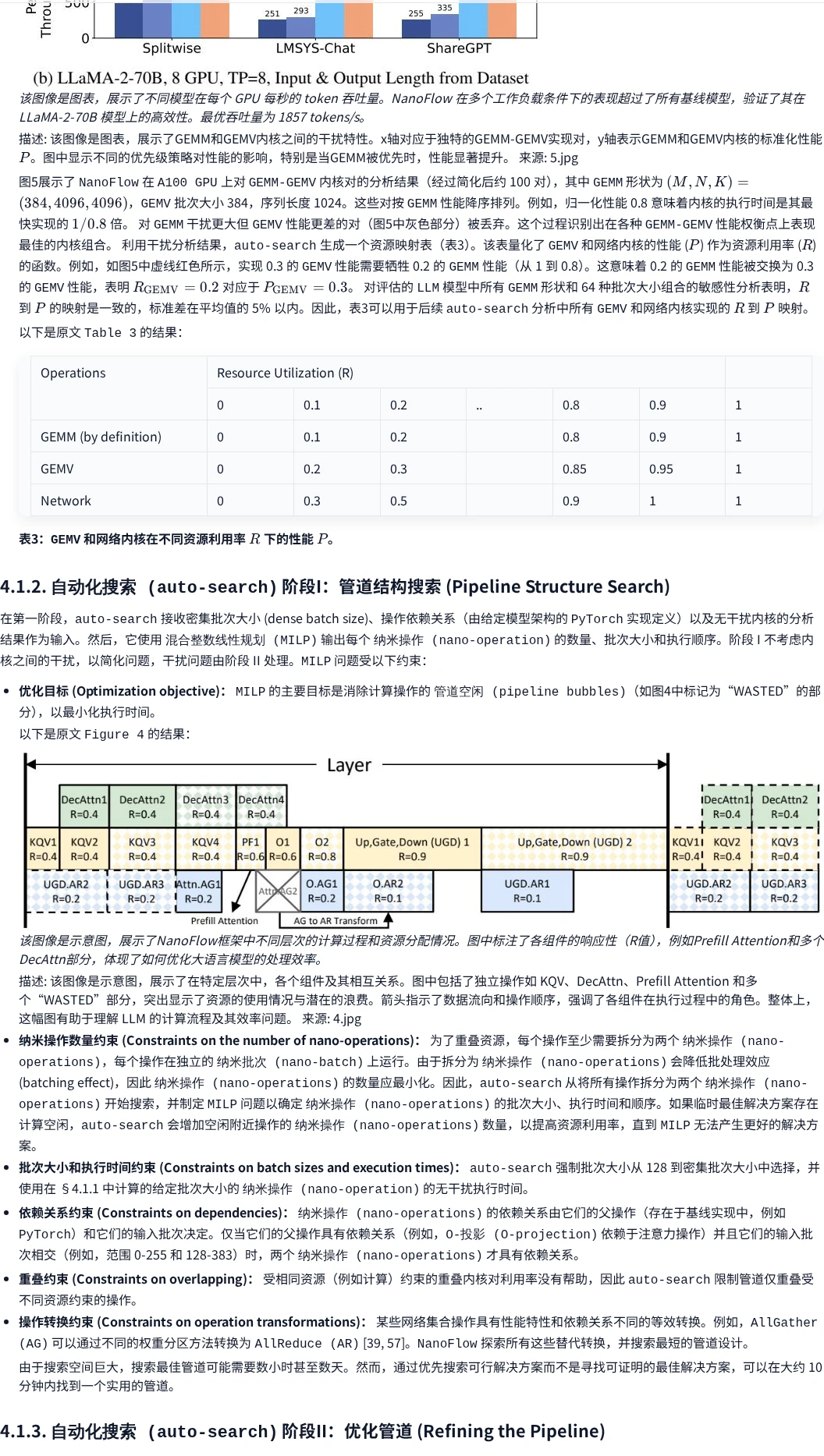

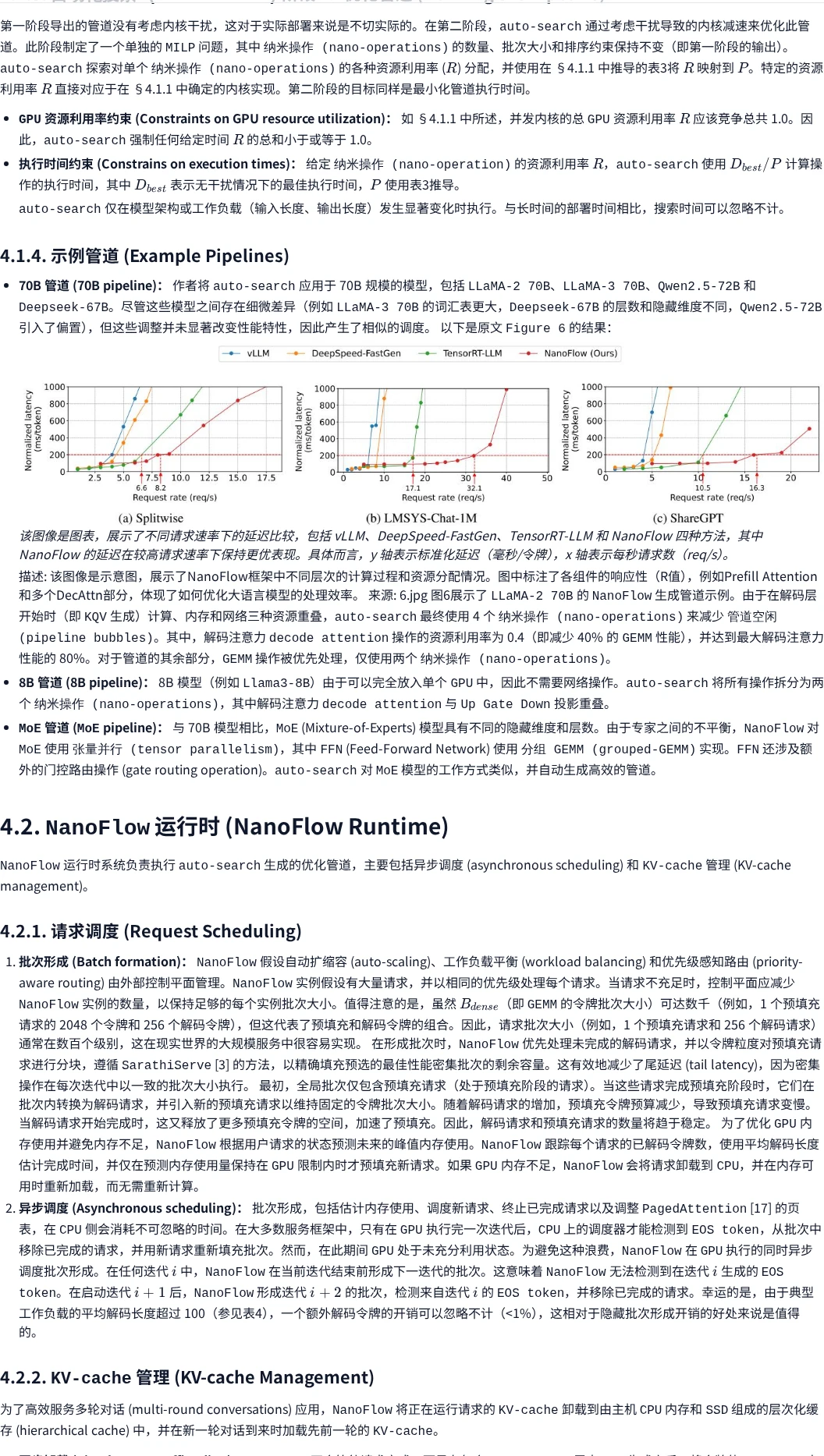

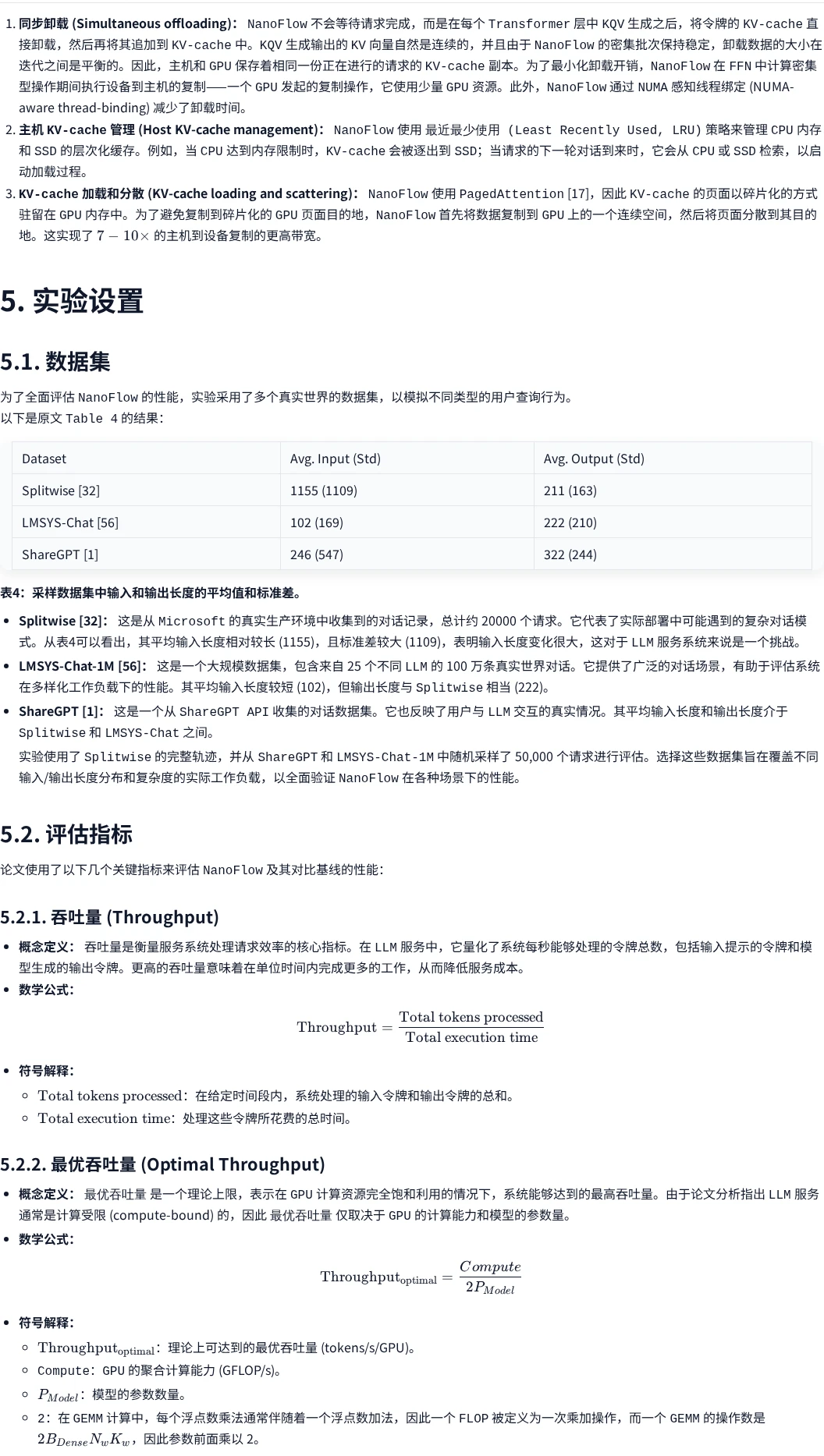

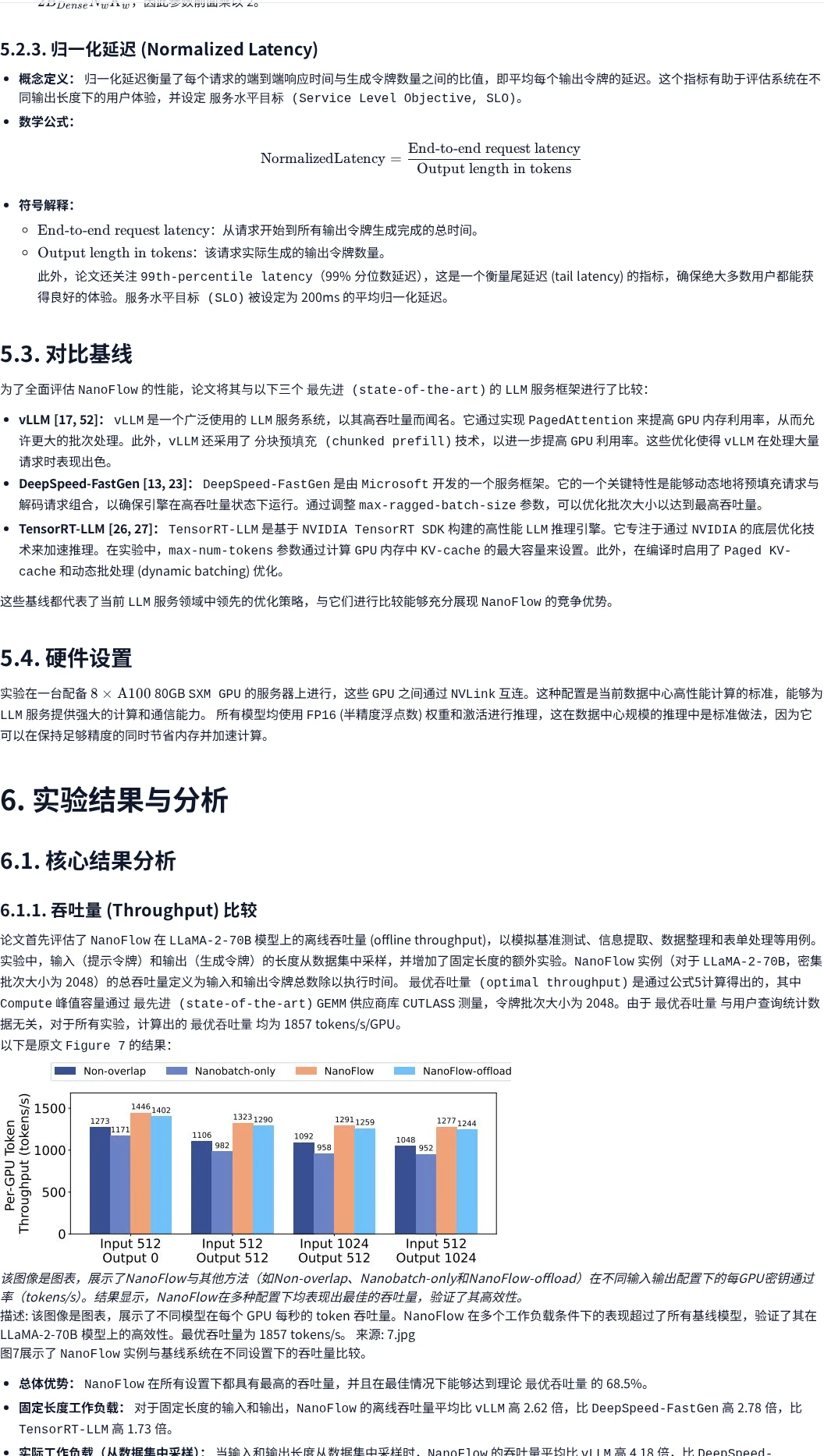

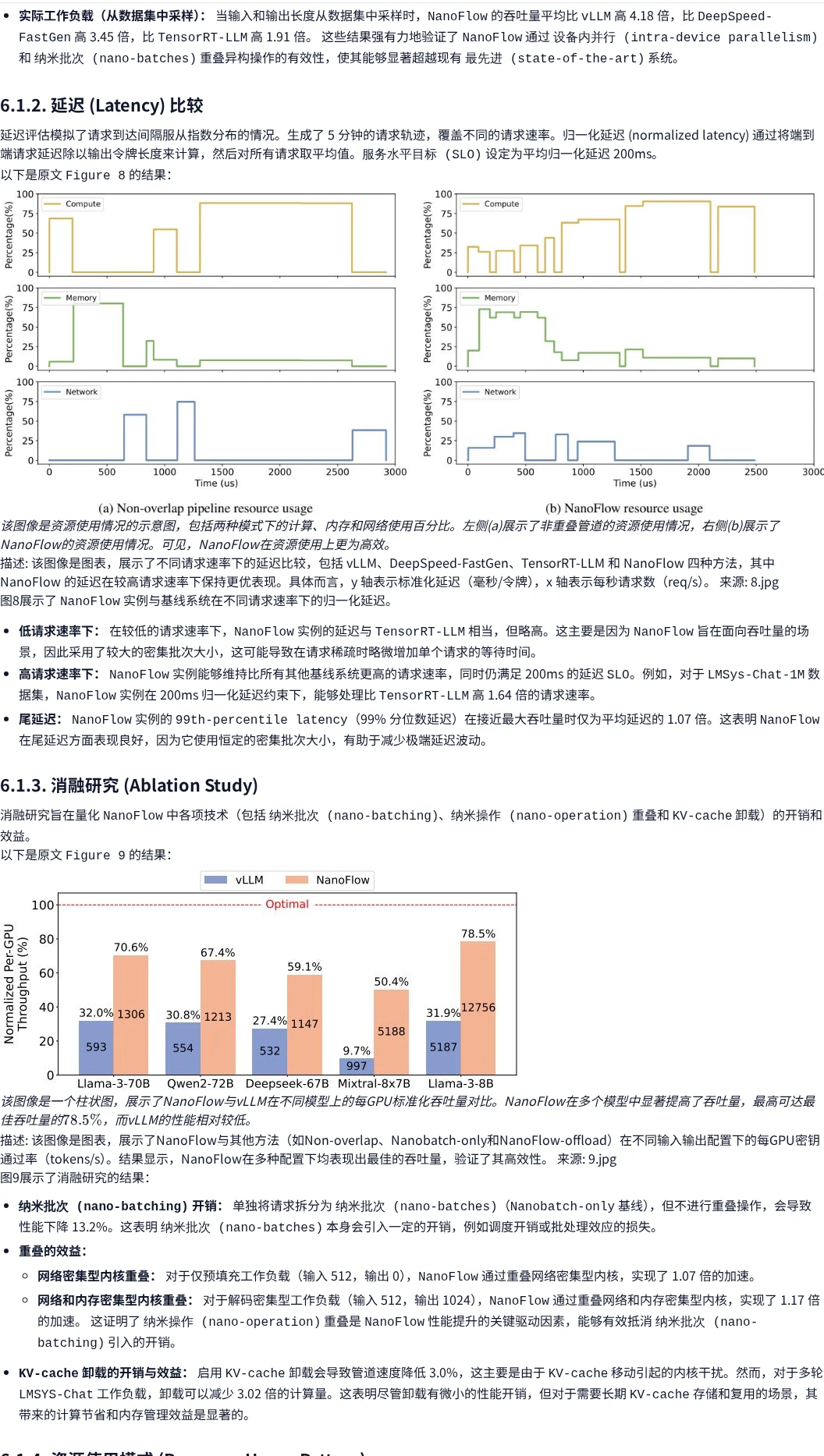

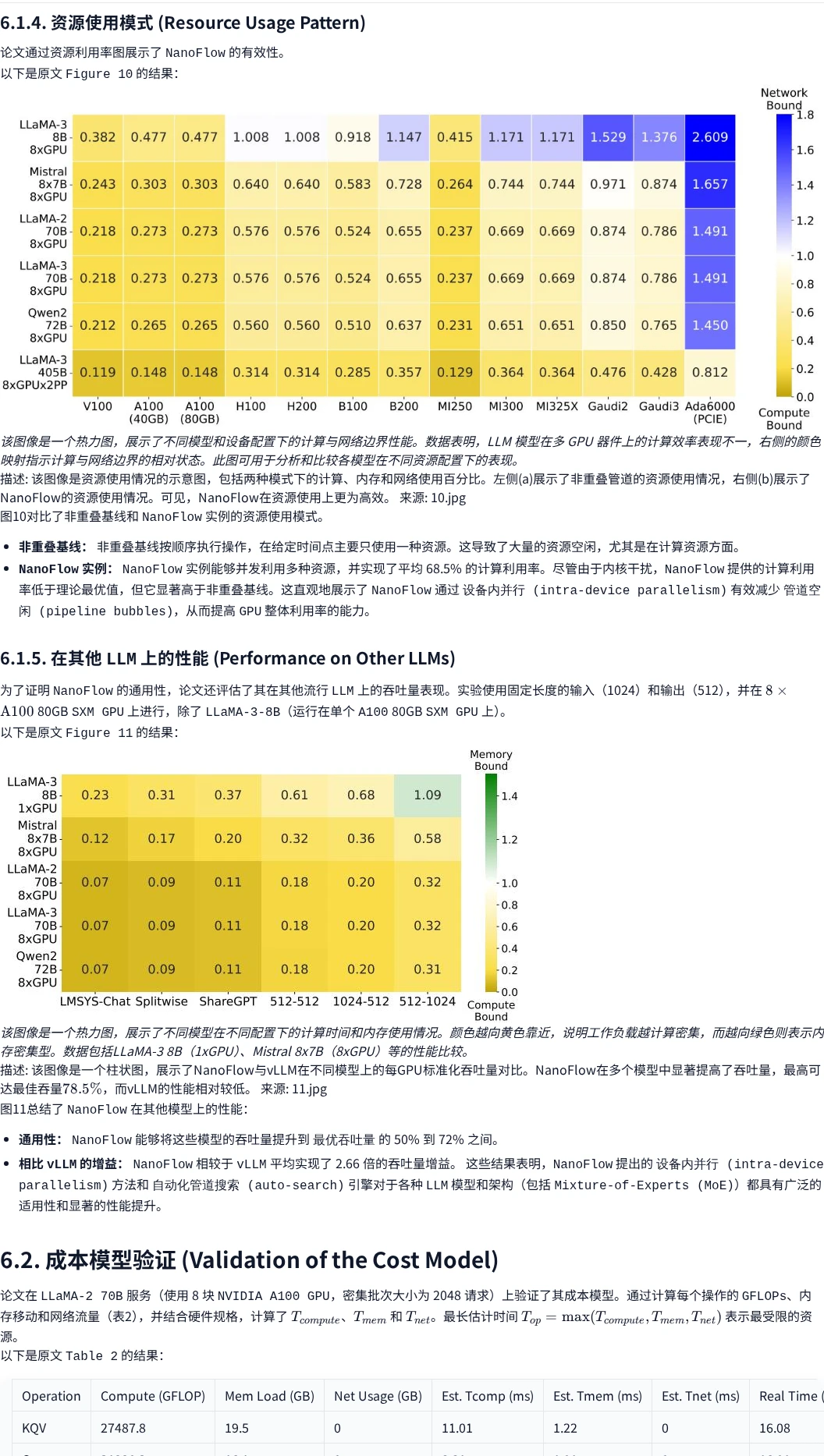

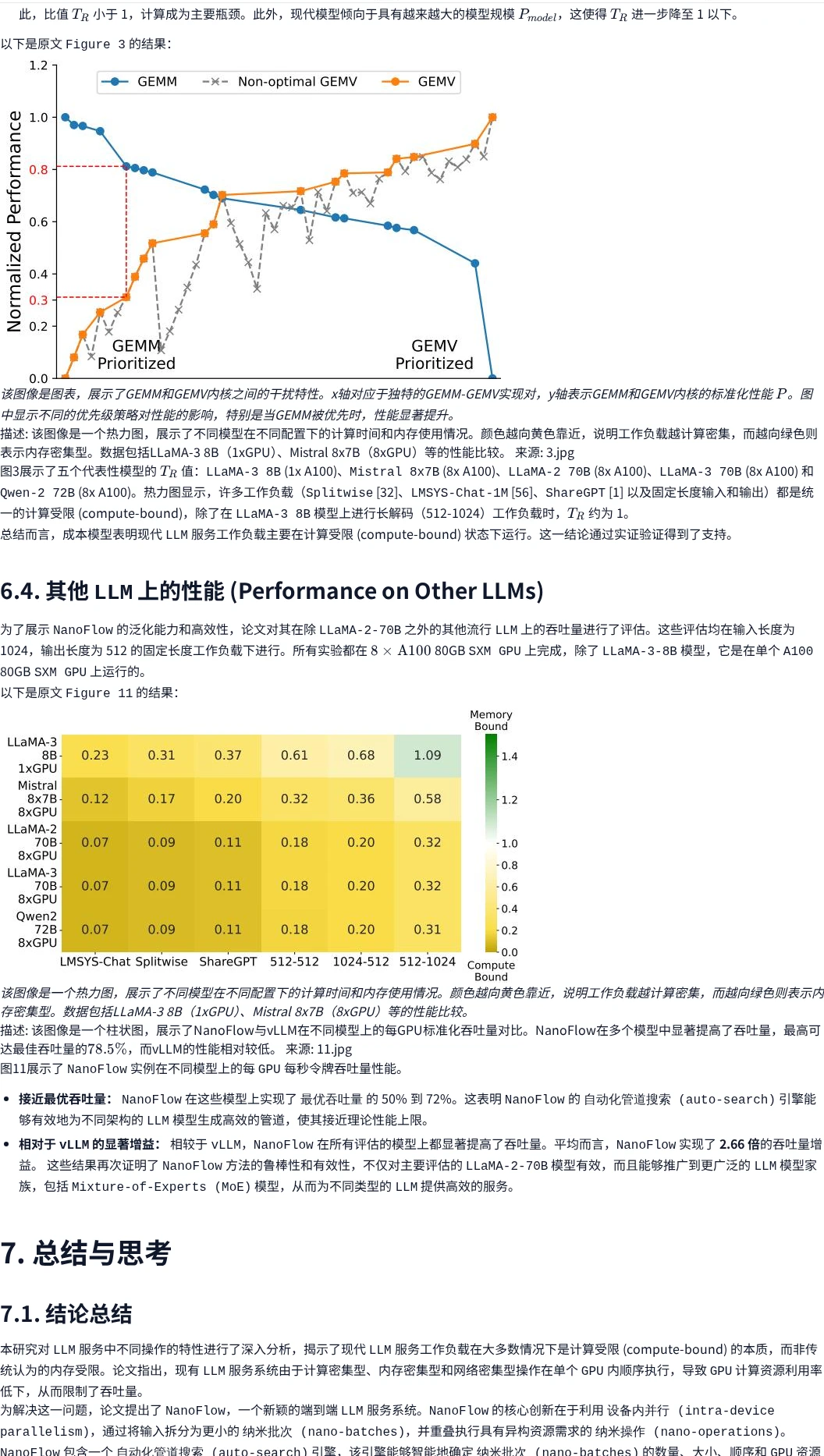

? 实验效果

在LLaMA-2-70B、Mixtral 8x7B等模型上,相比vLLM、DeepSpeed-FastGen等系统,吞吐量提升1.91倍,在其他模型上平均增益达2.66倍?

?️ #AI前沿 #论文解读 #LLM服务 #GPU优化 #NanoFlow #华盛顿大学 #大模型推理

NanoFlow通过设备内并行和纳米批次技术,将LLM服务吞吐量提升1.91倍,达到理论最优的50%-72%?

? 资源链接

原文链接: arxiv.org/abs/2408.12757

? 中文精读电脑版查看:www.aipaper.cc/zh/paper/691ca07c25edee2b759f339c

? 研究动机

传统观点认为LLM服务是内存受限的,但实际分析发现端到端服务是计算受限的?。现有系统因异构操作顺序执行导致GPU计算资源利用率低下。

?️ 创新方案

NanoFlow框架将输入拆分为纳米批次,通过自动化管道搜索引擎智能调度计算、内存和网络操作的重叠执行。

? 实验效果

在LLaMA-2-70B、Mixtral 8x7B等模型上,相比vLLM、DeepSpeed-FastGen等系统,吞吐量提升1.91倍,在其他模型上平均增益达2.66倍?

?️ #AI前沿 #论文解读 #LLM服务 #GPU优化 #NanoFlow #华盛顿大学 #大模型推理