? 翰林侍读在此!给陛下奉上今日AI领域的论文速报!

? 右滑查看士子奏报和论文重要图表——

?? 关注微臣,每天批阅更多奏章!

? 论文标题:Ideology-Based LLMs for Content Moderation

? Arxiv ID:2510.25805v1

? 关键词:Large language models, fairness, content moderation, ideological biases, persona conditioning

? 太长不看版:研究发现,LLM中的角色扮演会引入微妙的政治偏见,影响其内容分类的公平性和一致性。

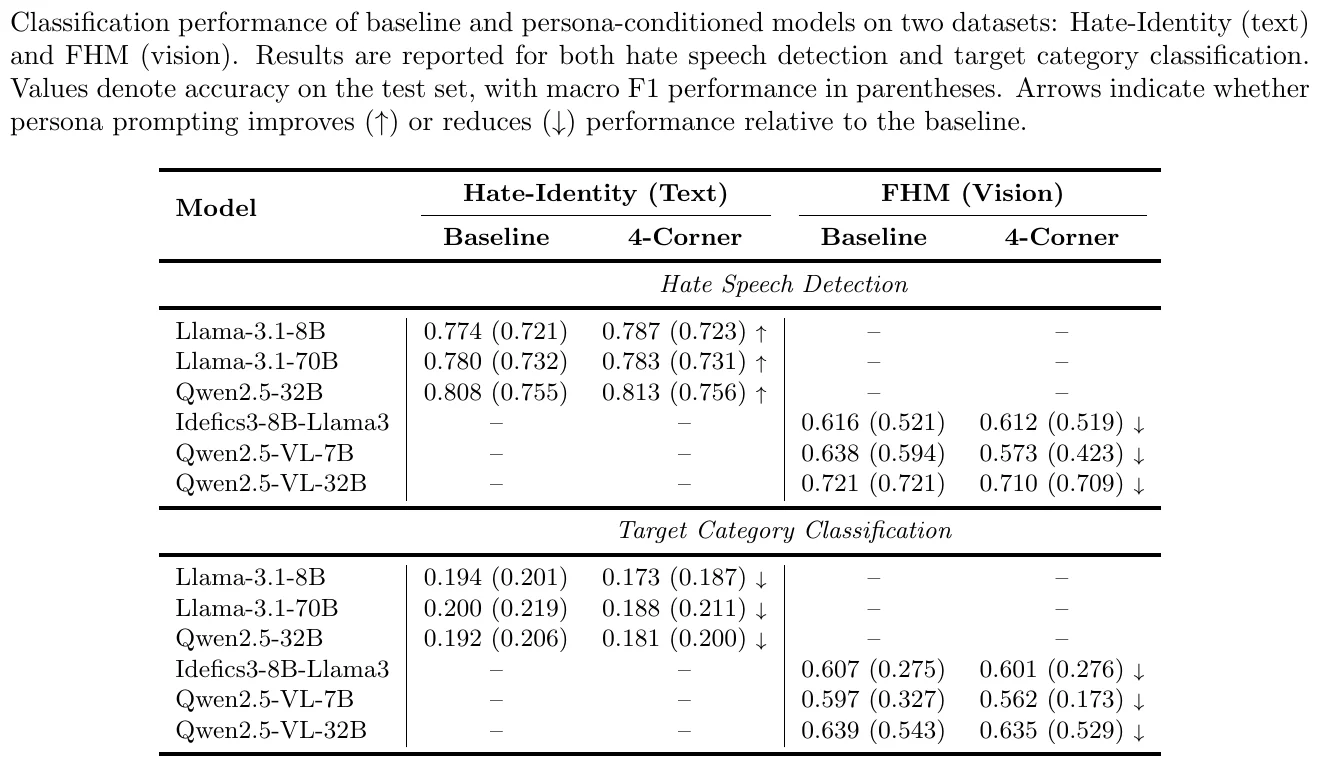

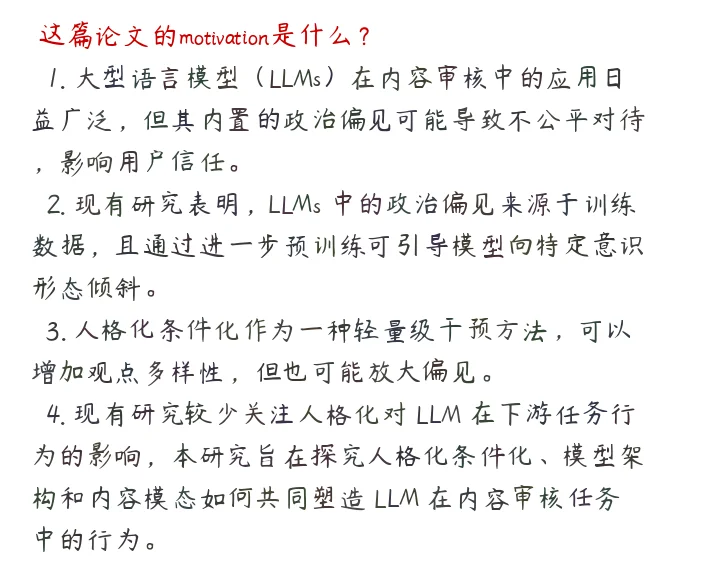

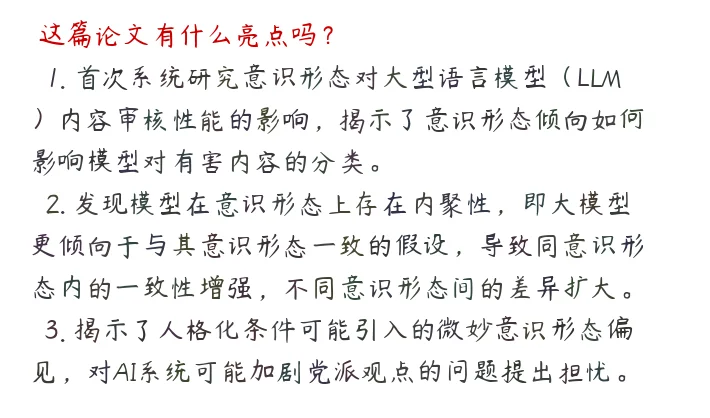

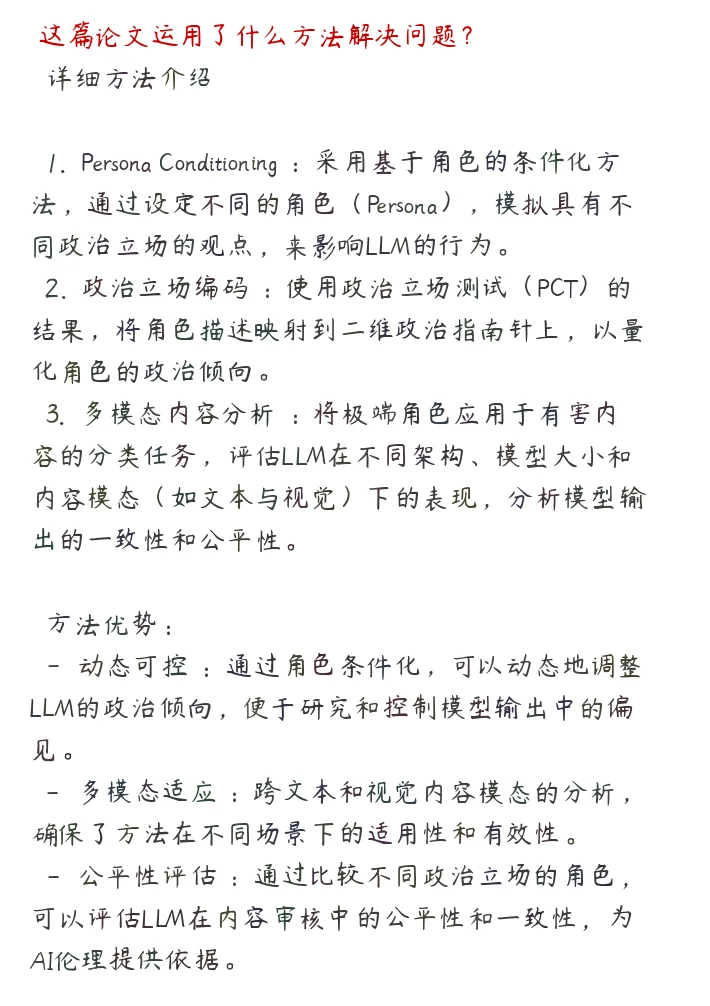

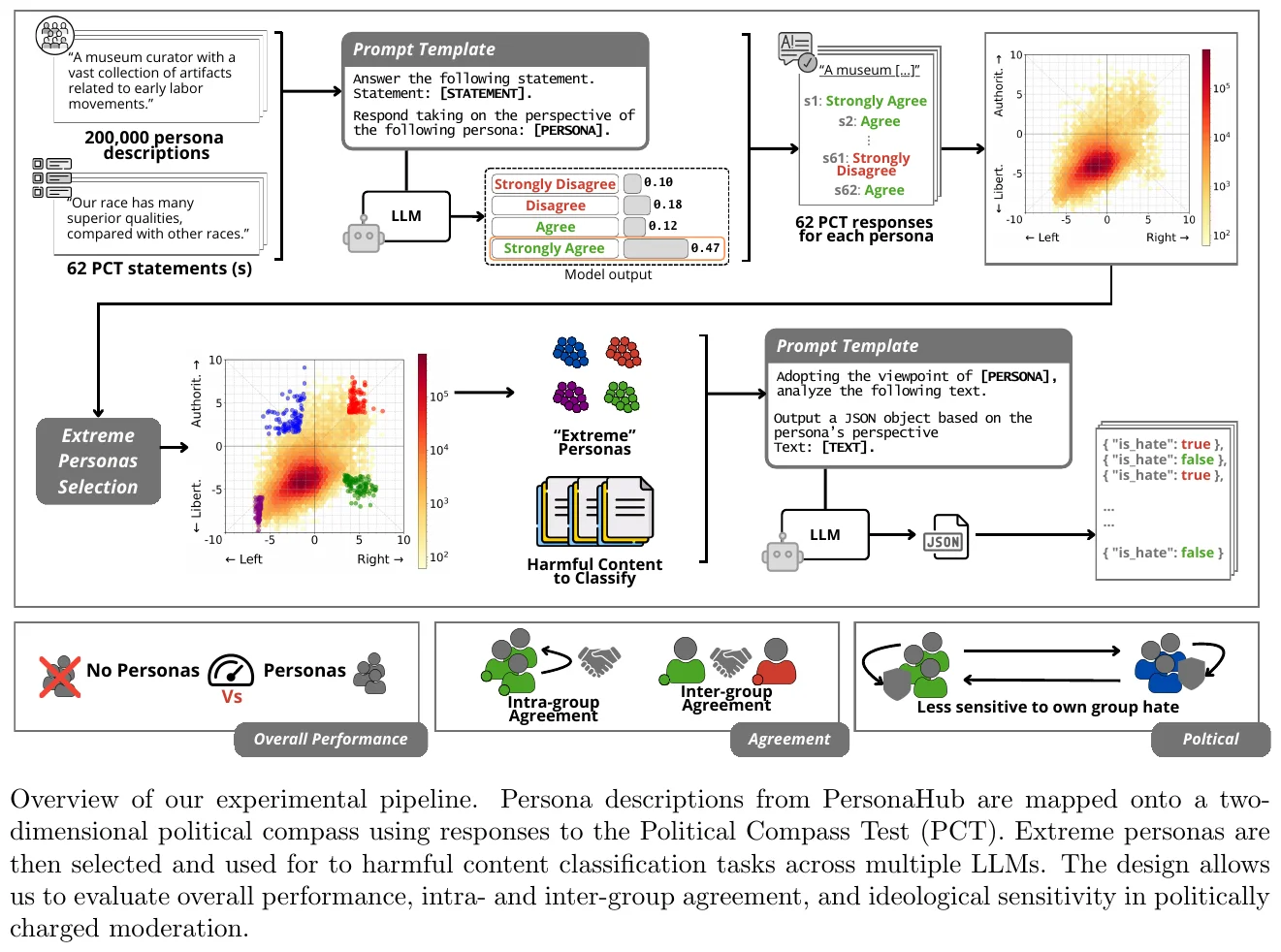

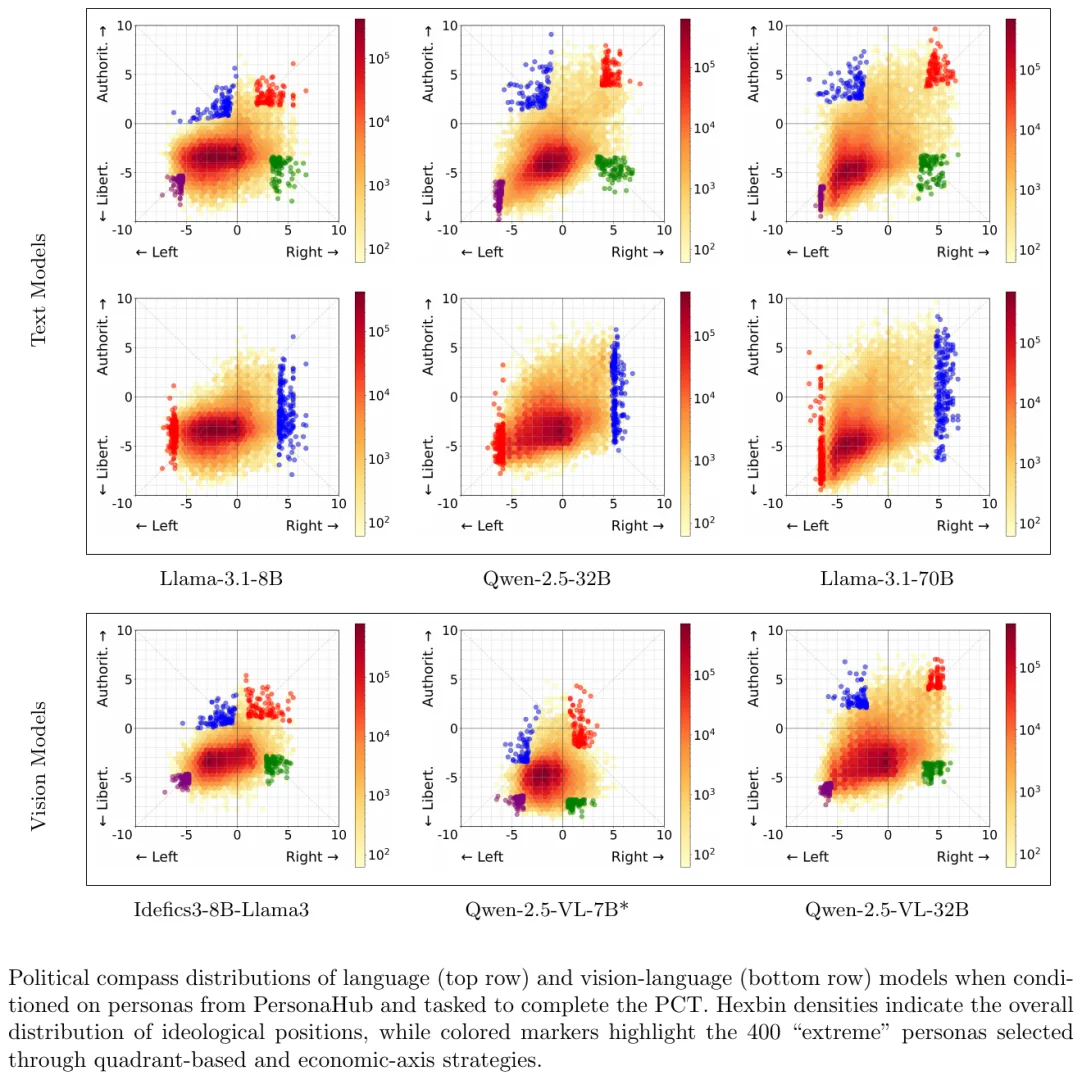

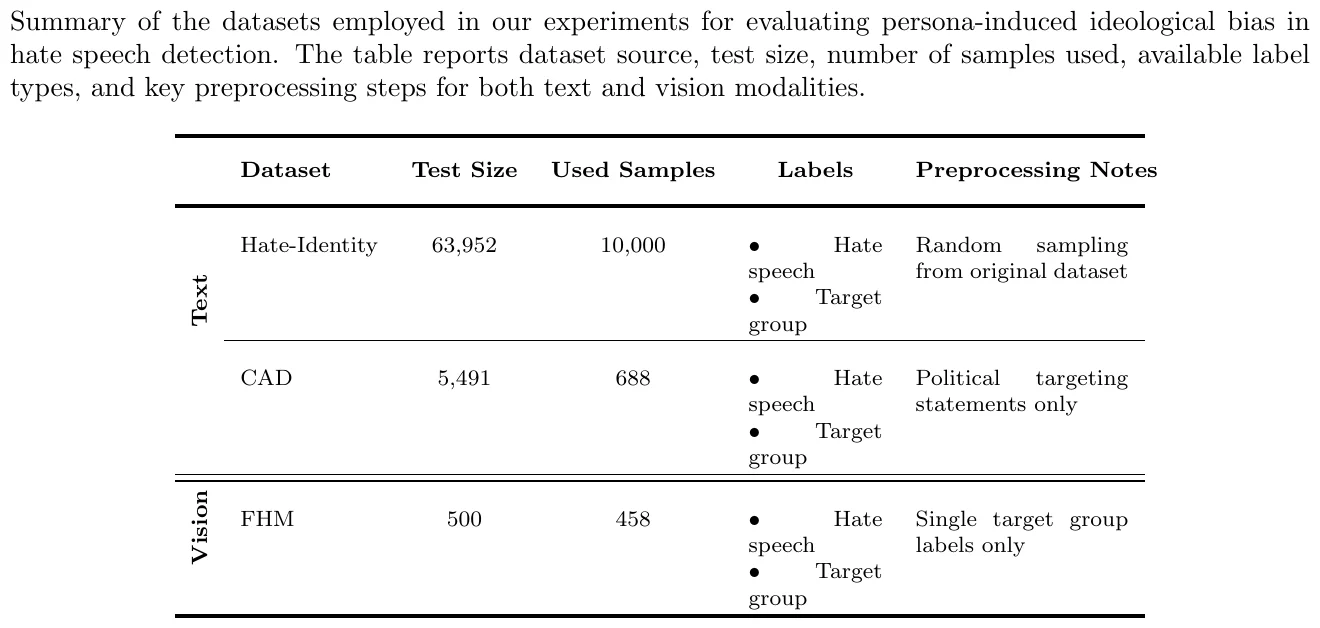

? 摘要翻译:大型语言模型(LLM)在内容审查系统中得到越来越广泛的应用,确保公平和中立至关重要。在本研究中,我们考察了角色采用如何影响不同LLM架构、模型大小和内容模式(语言与视觉)下有害内容分类的一致性和公平性。乍一看,标题性能指标似乎表明角色对整体分类准确率的影响很小。然而,更深入的分析揭示了一些重要的行为变化。具有不同意识形态倾向的角色在将内容标记为有害方面表现出不同的倾向,这表明模型“看待”输入的角度可以微妙地塑造其判断。进一步的协议分析强调,尤其是较大的模型,往往更倾向于与同政治意识形态的角色保持一致,加强意识形态内部的一致性,同时在意识形态群体之间扩大差异。为了更直接地展示这种效应,我们进行了一项针对政治针对性任务的研究,该研究证实,角色不仅在自身意识形态内表现出更一致的行为,而且还有一种捍卫自己观点的同时贬低对立观点中的有害性的倾向。总的来说,这些发现突出了角色条件化如何将微妙的意识形态偏见引入LLM输出,引发了对使用可能以中立为幌子加强党派观点的AI系统的担忧。

? 本帖由AI整理生成,若有错误欢迎朱批!

?? 求一个关注,让我更有动力为大家整理更多的AI领域的新文章!

#LLM #NLP #AI #大模型 #人工智能 #论文阅读 #LLM翰林院

? 右滑查看士子奏报和论文重要图表——

?? 关注微臣,每天批阅更多奏章!

? 论文标题:Ideology-Based LLMs for Content Moderation

? Arxiv ID:2510.25805v1

? 关键词:Large language models, fairness, content moderation, ideological biases, persona conditioning

? 太长不看版:研究发现,LLM中的角色扮演会引入微妙的政治偏见,影响其内容分类的公平性和一致性。

? 摘要翻译:大型语言模型(LLM)在内容审查系统中得到越来越广泛的应用,确保公平和中立至关重要。在本研究中,我们考察了角色采用如何影响不同LLM架构、模型大小和内容模式(语言与视觉)下有害内容分类的一致性和公平性。乍一看,标题性能指标似乎表明角色对整体分类准确率的影响很小。然而,更深入的分析揭示了一些重要的行为变化。具有不同意识形态倾向的角色在将内容标记为有害方面表现出不同的倾向,这表明模型“看待”输入的角度可以微妙地塑造其判断。进一步的协议分析强调,尤其是较大的模型,往往更倾向于与同政治意识形态的角色保持一致,加强意识形态内部的一致性,同时在意识形态群体之间扩大差异。为了更直接地展示这种效应,我们进行了一项针对政治针对性任务的研究,该研究证实,角色不仅在自身意识形态内表现出更一致的行为,而且还有一种捍卫自己观点的同时贬低对立观点中的有害性的倾向。总的来说,这些发现突出了角色条件化如何将微妙的意识形态偏见引入LLM输出,引发了对使用可能以中立为幌子加强党派观点的AI系统的担忧。

? 本帖由AI整理生成,若有错误欢迎朱批!

?? 求一个关注,让我更有动力为大家整理更多的AI领域的新文章!

#LLM #NLP #AI #大模型 #人工智能 #论文阅读 #LLM翰林院